AAAI上新 | 从生成检索、跨语言迁移,到负责任的视觉合成

2024-02-21 | 作者:微软亚洲研究院

编者按:欢迎阅读“科研上新”栏目!“科研上新”汇聚了微软亚洲研究院最新的创新成果与科研动态。在这里,你可以快速浏览研究院的亮点资讯,保持对前沿领域的敏锐嗅觉,同时也能找到先进实用的开源工具。

2月20日至2月27日,国际顶级人工智能学术会议之一的 AAAI 大会在加拿大举办。本期“科研上新”将为大家带来多篇微软亚洲研究院入选 AAAI 2024 的精选论文解读,涉及领域涵盖全景图像生成、生成式检索、跨语言迁移、可靠视觉合成,以及文本扩散。

本期内容速览

HORIZON: 高分辨率语义可控的全景图像合成

论文链接:https://www.microsoft.com/en-us/research/publication/horizon-high-resolution-semantically-controlled-panorama-synthesis/

项目链接:https://github.com/naykun/HORIZON

构建全方位的360度视觉景观,来实现用户对虚拟世界深度体验的追求,是未来技术发展的重要课题之一。近年来,尽管图像合成技术在语义引导内容生成方面取得了显著进展,但在打造身临其境的场景时,依然存在挑战,例如如何解决视角变化引发的内容扭曲问题,以及在确保合成效率与视觉一致性的同时,如何提供更为清晰的视觉体验等等。

针对这些挑战,微软亚洲研究院的研究员们推出了名为 HORIZON 的高分辨率全景图生成框架。该框架利用精心设计的球面建模技术,有效解决了球面扭曲和边缘不连续的问题。此外,HORIZON 还为用户提供了通过图像与文本输入来进行精确的语义控制,同时利用并行解码技术显著提高了全景图生成的效率。

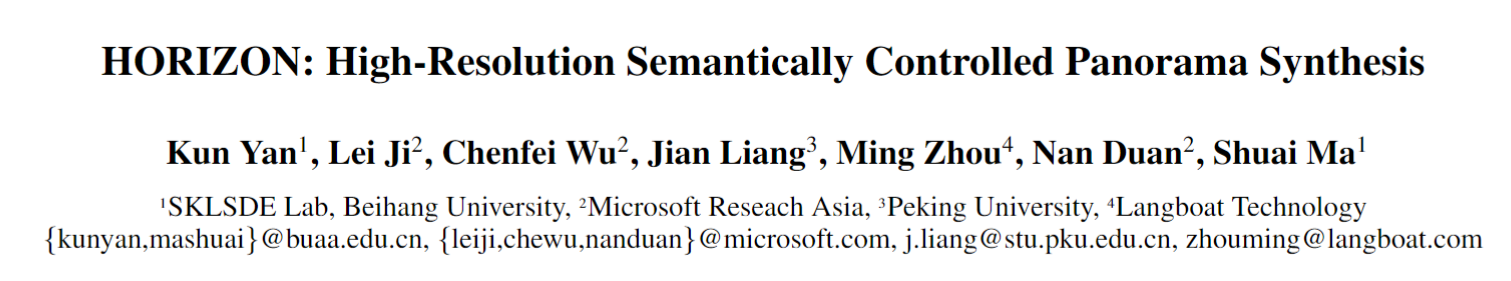

具体而言,实现大尺度图像生成的传统思路包括两类:一是先低分再超分,二是直接拆分为 patch 逐个生成。然而,先低分再超分在复杂场景中存在着细节语义缺失的问题,因此本研究聚焦于第二种思路。第二种思路最基本的实现方式被称之为 ARM(auto regressive modeling),以自回归的方式生成逐个 patch,在每个 patch 内自回归地生成每个 token,这种方式效率极低,且新 token 的生成只依赖于之前生成的 token,并不符合视觉内容天然的统计规律。

为了提升生成效率,一个自然的改进就是使用局部并行生成策略,即 LPM(local parallel modeling),实验表明,这样的策略虽然提升了速度,但生成质量却出现了明显下滑。这是因为并行解码时局部 token 的互相制约减弱,对于全景图像这种不同位置像素分布规律有显著差别的场景,性能会相应地出现退化现象。因此,研究员们进一步提出了 SPM(spherical parallel modeling)方案,通过引入球形位置编码以及球状依赖关系,增强了生成过程中的局部和全局约束,使得生成过程兼顾了 LPM 的速度和超越 ARM 的性能。同时,球面建模的方法自然地解决了图像左右边缘不连续、球面投影扭曲这类经典框架难以解决的问题。

图1:研究员们的建模策略从 ARM 开始,逐步过渡到 LPM,最终发展为 SPM,实现了高效率与高保真度的双重目标。在此图中,红色框表示当前需要生成的视图区域,而蓝色框则展示了条件窗口。

HORIZON 的方法在室内外数据集上的无条件生成、视野扩展和语义控制生成任务中都经历了严格评估,并在定量指标和定性指标上均显示出卓越的表现。未来,研究员们将继续提升全景合成在可控性、效率和真实感方面的水平,为全景视觉合成技术的发展设定新的高标准。

排序学习用于生成式检索

论文地址:https://www.microsoft.com/en-us/research/publication/learning-to-rank-in-generative-retrieval/

项目地址:https://github.com/liyongqi67/MINDER

生成式检索是一种新的搜索范式,它将搜索任务转为从用户查询到文档标识符的序列生成任务。生成式检索无需传统的索引,而是利用生成式大模型的最新进展来提供更准确的搜索结果。根据文档标识符的不同,生成式检索分为以 DSI [1]和 SEAL [2]为代表的不同类型。本研究仅讨论以 SEAL 为代表的用文档内容为标识符的生成式检索。

SEAL 采用文档中的文字片段作为标识符,并使用序列生成模型从用户查询生成对应文档的文字片段。使用文字片段作为标识符的优势在于其天然的语义特征,能够充分利用预训练语言模型的语言理解能力。然而,这种方法的不足之处在于标识符和文档之间并非一一对应,因此需要额外的步骤来建立标识符与文档之间的对应关系。SEAL 设计了一个复杂的启发式规则来完成此步骤。由于序列生成模型和启发式规则都没有直接优化检索结果,因此这种方法得到的检索结果欠佳。

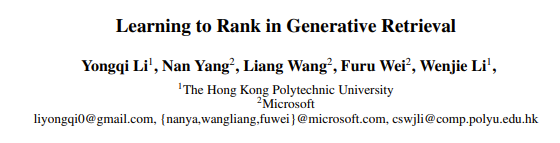

针对此问题,微软亚洲研究院的研究员们采用了一种基于排序学习的生成检索式方法(LTRGR)。LTRGR 生成式检索能够直接学习序列排序目标,将生成模型的优化目标和排序结果统一起来。这种学习方法只需要一个额外的排序学习阶段,在推理时没有额外的消耗。

图2:LTRGR 方法包含两个训练阶段:(a)生成学习;(b)排序学习

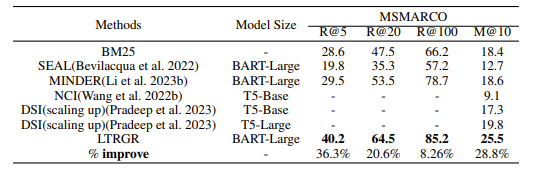

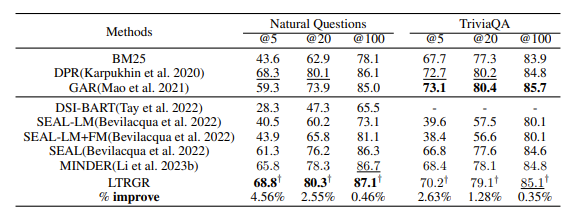

研究员们在常用的检索基准数据集 NQ、TriviaQA 和 MSMARCO 上进行了实验。实验结果表明,LTRGR 方法显著优于其他生成式检索模型,达到了目前最先进的生成式检索的结果。

图3:实验结果

相关论文:

[1] Transformer Memory as a Differentiable Search Index

https://arxiv.org/abs/2202.06991

[2] Autoregressive Search Engines: Generating Substrings as Document Identifiers

https://arxiv.org/abs/2204.10628

使用机器创建的通用语言实现更好的跨语言迁移

论文链接:https://www.microsoft.com/en-us/research/publication/machine-created-universal-language-for-cross-lingual-transfer/

目前处理跨语言迁移问题的主要方法有两类:一是多语言预训练,它通过构建多语言编码器,用英语进行微调后直接在其他语言中测试;二是翻译测试方法,它将其他语言的测试集翻译成中间语言(如英语)进行测试。比较而言,翻译测试方法更具可解释性,但其性能弱于多语言预训练,并且由于翻译会改变词语顺序,所以导致其在词语级别任务中难以应用。

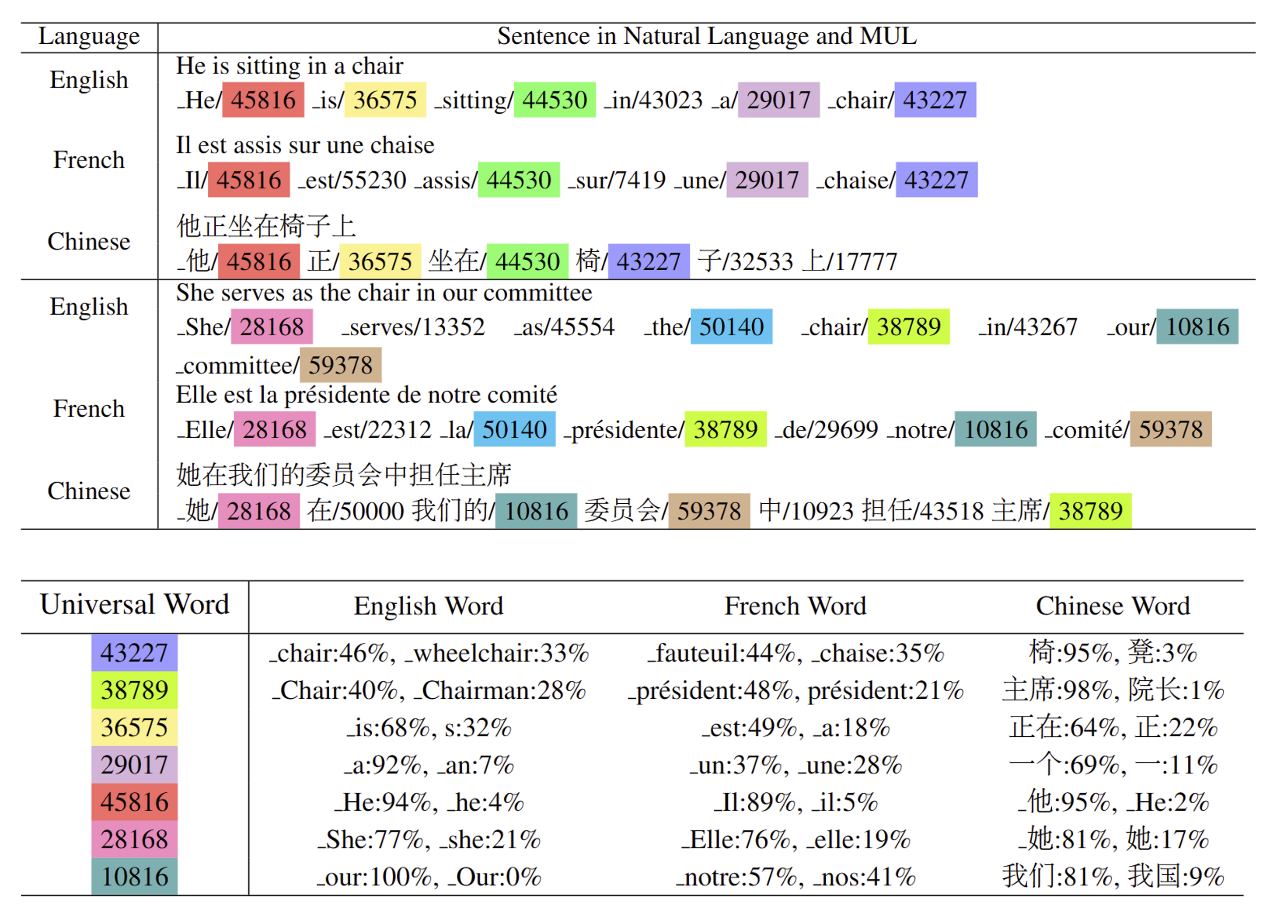

针对上述问题,微软亚洲研究院的研究员们提出了一个新颖的概念——机器创建的通用语言(MUL)。MUL 包含一组离散符号,构成通用词汇,并配有自然语言到 MUL 的翻译器,用于将多种自然语言转换为 MUL。通过将不同语言中的共享概念映射到相同的通用词汇,MUL 有效提高了跨语言转移的效果。此外,MUL 保留了特定语言的词汇和词序,使得模型更易于应用到词语级别的任务。图4为将英语、法语和中文翻译到 MUL 的例子。

图4:图片中上半部分为将英语、法语和中文的句子映射到通用语言后的结果,下半部分为通用语言中词语和不同语言词语的对应关系。同一个通用语言的词语用同一个颜色标出。

具体来说,首先,研究员们通过多语言掩码语言模型(MLM)损失进行预训练,利用无监督方法在双语数据上生成词对齐指导,以创建 MUL。紧接着,研究员们进一步使用句间对比学习方法,增强了不同语言中词嵌入的对齐效果。最后,引入具有跨语言对齐的向量量化(VQ-CA)来提高通用词汇的可解释性。

研究员们在多个数据集上进行了实验,包括 XNLI、NER、MLQA 和 Tatoeba,使用 MUL 作为输入。与多语言预训练的组合词汇相比,该模型的词汇量更小,词嵌入层需要的参数更少。实验结果显示,即使参数减半,该模型性能与 XLM-R 相当,而在将词嵌入层节省的参数重新分配到 Transformer 权重后,性能更佳。进一步分析表明,MUL 具有很强的可解释性,因为相较于翻译成英语,翻译成 MUL 产生的歧义更少。

ORES: 开放词表下的可靠视觉合成

论文链接:https://www.microsoft.com/en-us/research/publication/ores-open-vocabulary-responsible-visual-synthesis/

项目地址:https://github.com/kodenii/ORES

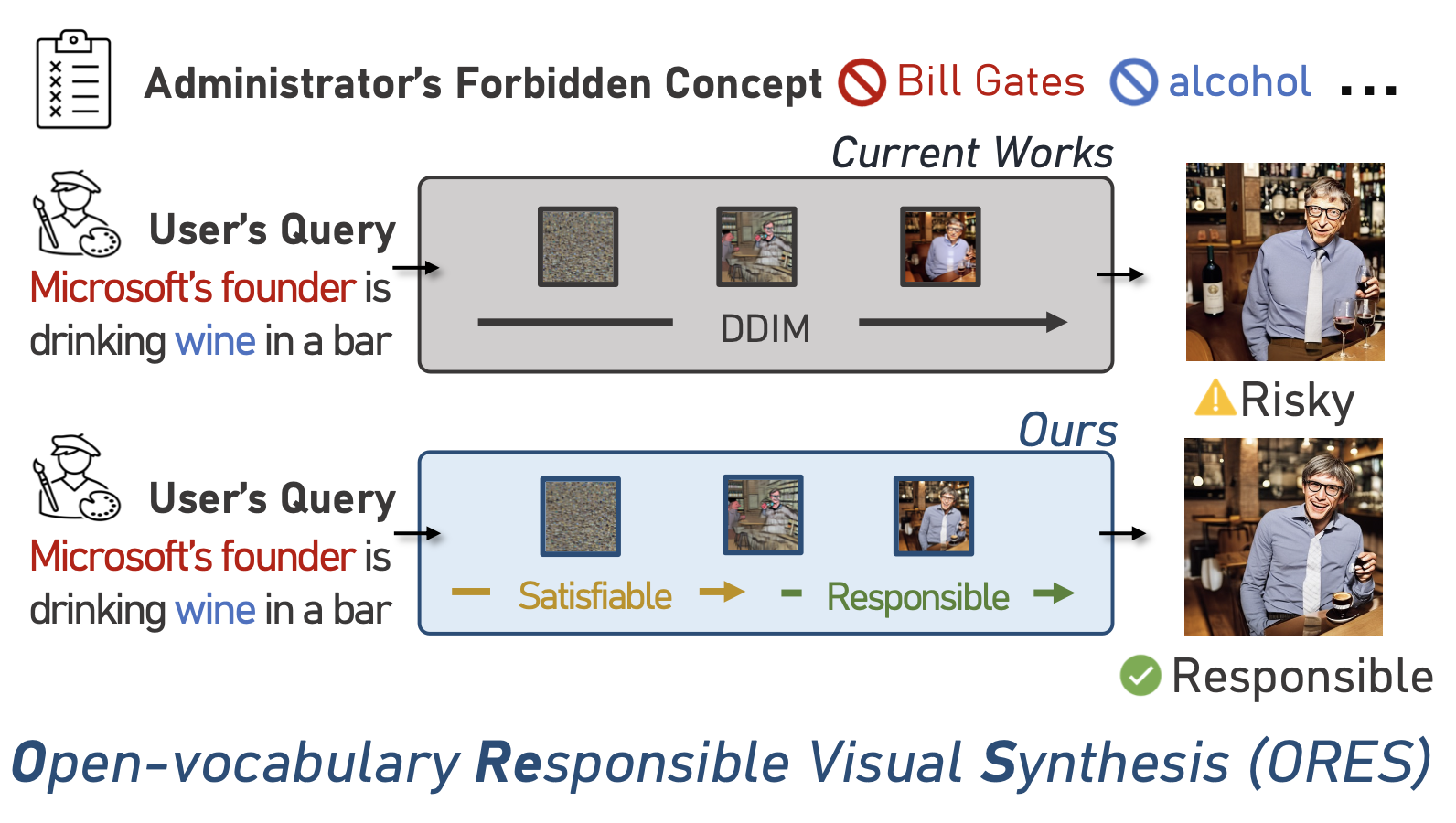

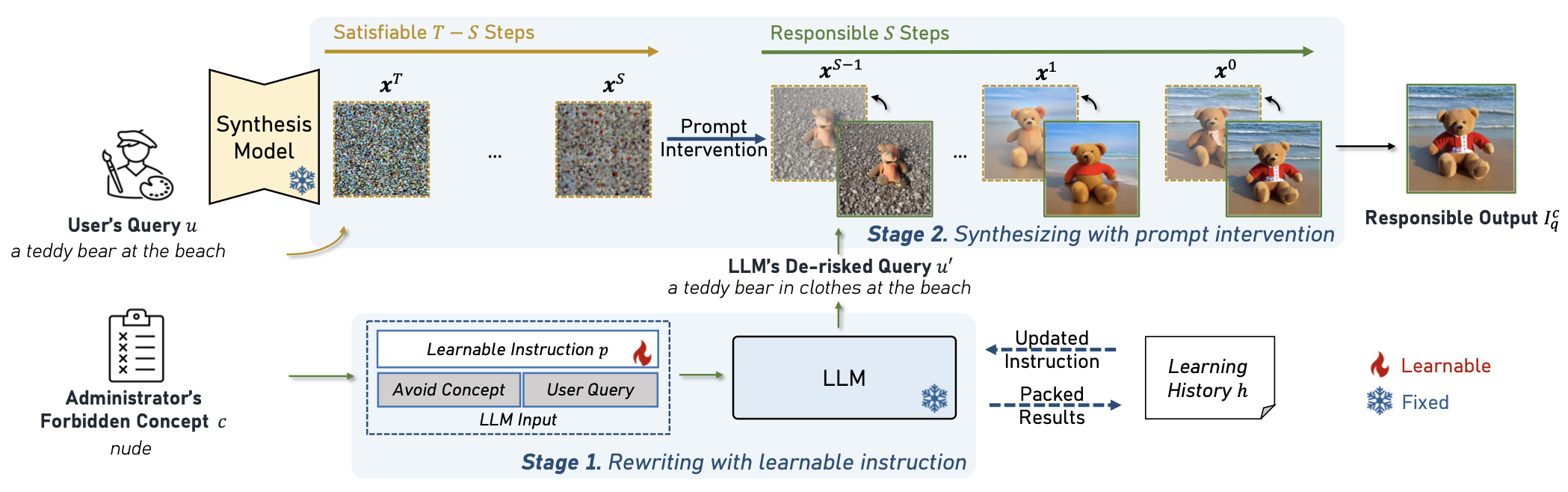

避免合成特定的视觉概念是负责任的视觉合成中的一个重要挑战。然而,负责任的视觉合成需要避免的视觉概念往往会因地域、上下文和使用场景的不同而有所不同。此外,在传统的视觉合成中,用户提供的“用户查询”,代表了用户希望由合成模型合成的图像的输入。微软亚洲研究院的研究员们发现,通过传统的视觉合成模型以及安全方法,用户可以轻松绕过安全机制合成包含风险的概念如酒精、暴力或知名人物,使得视觉合成的安全问题变得非常真实。

基于此,研究员们提出了一个新的任务 ORES,即开放词汇表下的负责任的视觉合成以及对应的解决方案 TIN 框架。

在 ORES 中,管理员将提供一部分输入,即禁止的概念,这可能包括一些具有版权风险或安全问题的概念,要求模型避免合成管理员禁止的概念以及相关的概念。即使在用户的查询中没有直接提及这些概念,这些限制也将发挥潜在的作用。

图5:开放词汇表下的负责任的视觉合成(ORES)任务

TIN 框架的处理流程则主要分为两个阶段。首先,使用大语言模型将用户的查询重写为低风险的查询。然后,使用低风险的查询干预来合成过程。具体来说,用户提供查询后,TIN 将在第一阶段使用用户查询进行合成,并在后续的负责任阶段中使用低风险查询进行干预。通过这个过程,最终可以得到负责任的视觉输出。

图6:TIN 框架的总体结构

ORES 是可靠视觉合成领域上全新的任务,为了推动后续研究的探索,研究员们开源了一套公开可用的数据集——基准和基线模型。不仅如此,实验结果表明,基线模型 TIN 在降低图像生成风险方面的有效性,是首个可以在开放词表上进行负责任视觉合成的方法。

ORES 是由微软亚洲研究院自然语言计算组在可靠视觉合成领域所建立的新范式,未来,研究员们将持续对相关问题进行更加深入的探索。

基于强化条件的文本扩散

论文链接:https://www.microsoft.com/en-us/research/publication/text-diffusion-with-reinforced-conditioning/

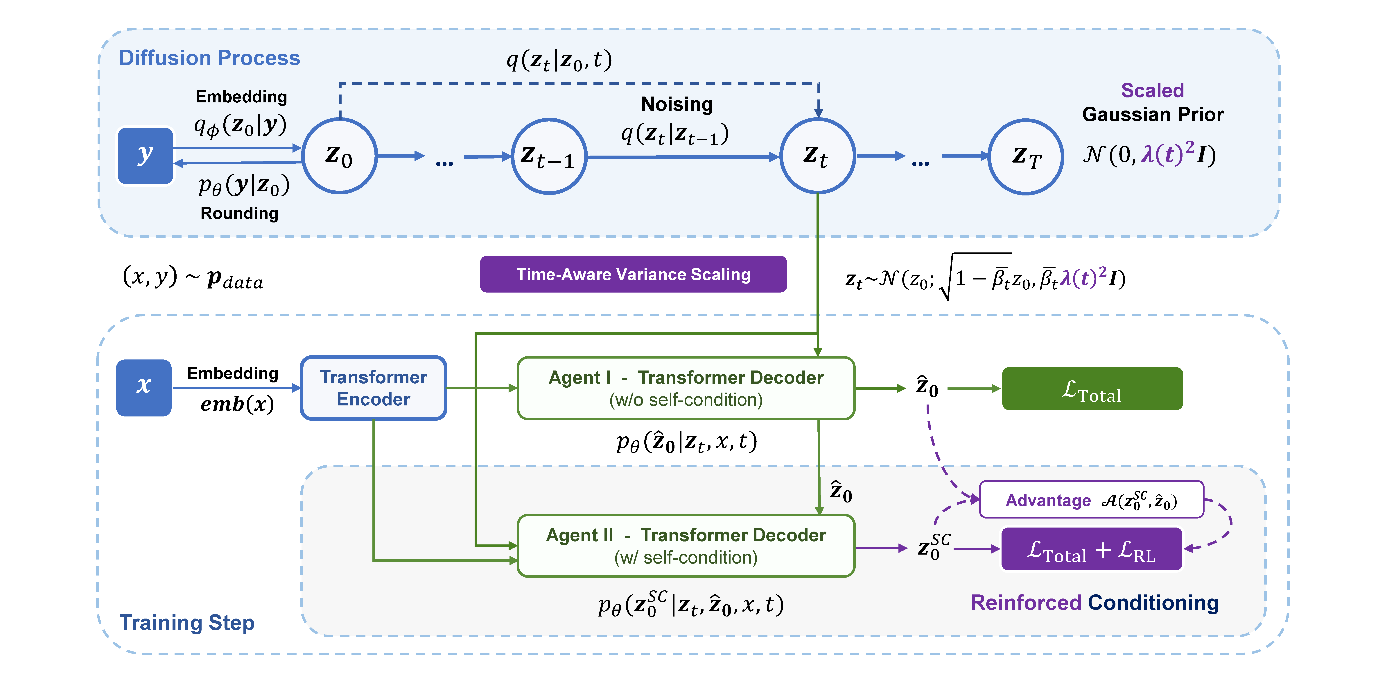

微软亚洲研究院的研究员们在研究扩散模型的训练和推断过程中,分析并发现了扩散模型在训练和推断中存在的两个潜在问题:一是自我条件推断的退化,即模型在推断时过分依赖上一时间步的预测结果,而忽略了去噪的潜在项,降低了生成质量;二是推断误差累积导致的生成文本与目标分布的偏离。

扩散模型一种常用的训练策略是自我条件(self-condition),它将模型对目标样本的预测结果作为去噪的条件之一,从而使模型可以在推断时利用上一时间步对去噪目标的预测作为当前时间步的去噪条件之一。然而研究员们发现,随着训练过程中去噪目标预测精度的不断提升,模型会逐渐倾向于对上一时间步的去噪目标进行简单的修改或重复,而忽略了去噪的潜在项,导致模型无法充分利用去噪步骤来迭代地提升生成质量。

为了解决这一问题,研究员们提出了一种基于强化学习的对扩散模型进行自我条件训练的方法。该方法通过引入奖励信号,引导模型更好地利用预测的去噪目标来进行降噪,从而缓解了推断时的退化现象。此外,研究员们还针对推断误差累积导致的偏移问题,提出了一种时间感知的方差调整方法,以通过增大模型训练时的采样空间,提高对推断偏差的容忍度。

图7:基于强化学习的对扩散模型框架图

研究员们在一系列文本生成任务上进行了实验,结果表明,该方法不仅可以提升生成文本的质量,而且可以更有效地利用扩散过程,只需数个时间步就能生成较高质量的预测文本,显著降低了文本扩散模型对大量去噪步数的依赖。