TSRFormer:复杂场景的表格结构识别新利器

2022-11-03 | 作者:多模态交互组

编者按:近年来,各大企业和组织机构都在经历数字化转型。将文档转换成计算机所能识别的样态,是数字化转型的关键步骤,如何识别出图片中表格具体的结构与内容,并直接提取其中的数据和信息是学术界和工业界共同瞩目的焦点。然而,目前的表格识别算法多用于识别横平竖直的表格,对于全无边界和实线的表格、行列之间存在大片空白区域的表格等日常生活中常见的表格还没有较好的解决方案,对于拍摄角度倾斜而表格边框弯曲等情况更是束手无策。今天我们将为大家介绍微软亚洲研究院在表格结构识别方向的最新进展,研究员们提出了一种新的表格结构识别算法 TSRFormer,能够较好地识别复杂场景中不同类型的表格。

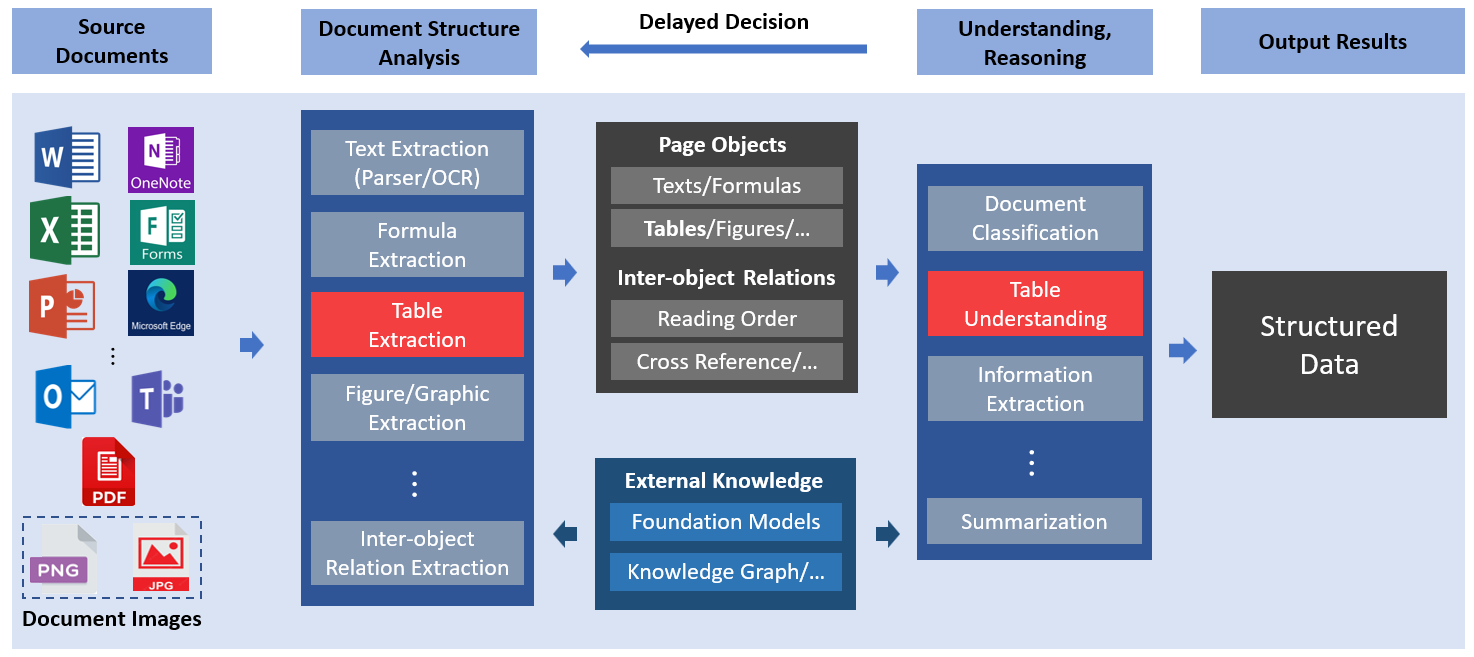

如今,各行各业正在向数字化转型,海量的文档型数据也源源不断地生成。用人工处理这些蕴含着丰富信息的文档,存在如耗时长、成本高、易出错等缺陷,在实际应用中难以高效执行。因此,社会对于自动化文档处理技术的需求日益增加,智能文档处理(IDP)成为了近几年的热点。与此同时,市场上也涌现出了许多相关产品,例如微软就提供了全方位的 IDP 服务及解决方案。如图1所示,智能文档处理通过光学字符识别(OCR)、文档图像分析、计算机视觉,以及自然语言处理等技术,将复杂的非结构化文档数据转变为能被计算机直接理解和使用的结构化数据,从而帮助企业或个人更加高效地获取文档中的有用信息。

图1:智能文档处理(IDP)的流程示意图

在各类文档中,表格作为一种高效的信息表达形式,通常被人们用来呈现结构化的数据,例如公司财报、发票、银行流水、实验数据、医院检验报告等等。如何抽取及理解表格的技术一直都是 IDP 中的重要组成部分。

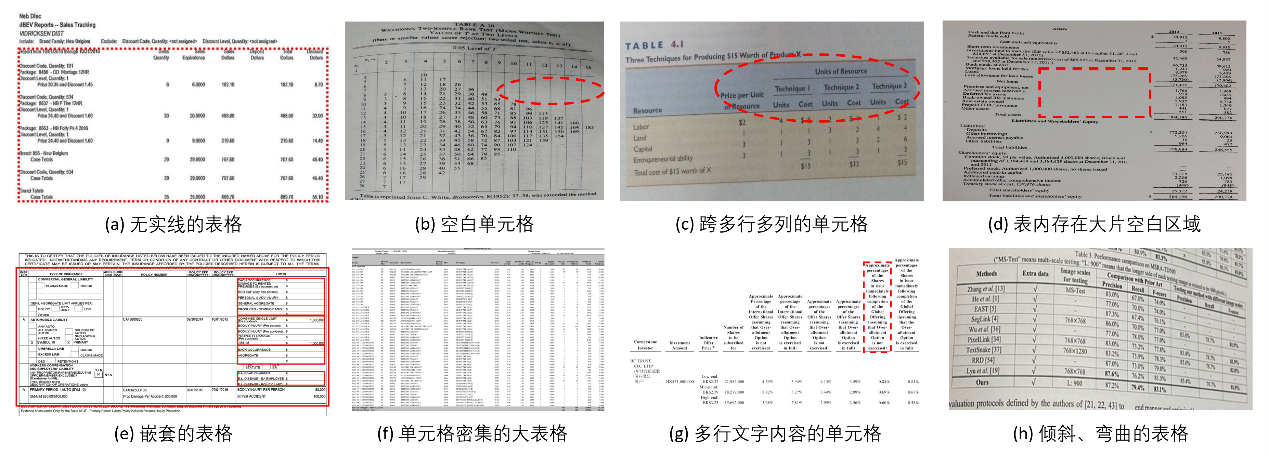

表格抽取技术解决的主要问题是如何自动地将图像中的表格数字化,其包含两个子任务:表格检测和表格结构识别。其中,表格结构识别旨在从表格的图像中还原表格的结构信息,包括每个单元格的坐标位置以及每个单元格所属的行列信息。如图2所示,在实际场景中,表格结构识别是一个极具挑战性的问题。其挑战的难度主要在于表格的结构与内容的复杂多样性,例如存在完全无边界和实线的表格、包含许多空白单元格或者跨行跨列单元格的表格、行列之间存在大片空白区域的表格、嵌套的表格、密集的大表格、单元格包含多行文字内容的表格等等。不仅如此,在相机拍摄的场景中,有些表格的边框可能因拍摄角度而倾斜或弯曲,这都大大增加了表格结构识别的难度。

图2:表格图像的多样性与复杂性

近年来,表格结构识别领域受到了学术界与工业界的广泛关注,其中涌现出了大量研究成果。但这些研究成果的视角大多仅限于简单的应用场景,例如 PDF 或扫描文档中横平竖直的表格或分割线均为实线的表格,而对于图2中这些在实际场景中经常出现的情况,尤其是倾斜、弯曲且没有实线的表格关注度较低。因此,现有的算法距离完全解决实际场景中的表格识别问题还存在很大差距。为了让表格识别技术适用于更广泛的应用场景,微软亚洲研究院的研究员们提出了一种新的表格结构识别算法 TSRFormer[1],该算法能够较好地识别复杂场景中不同类型的表格。

TSRFormer: 提供表格结构识别新思路

现有的表格结构识别算法大致分为三种范式:编码-解码范式、自底向上范式和拆分-合并范式。编码-解码范式下的模型在输入表格图像后可以直接预测表示表格结构的编码序列(如 HTML、LaTeX 等)。该范式即使在识别较为容易的横平竖直表格的任务中,仍然需要远超于其他范式的训练数据才能产出较好的效果。若要进一步支持倾斜或弯曲的表格,则还需额外收集大量的数据,因此研发成本较高。此外,目前基于该范式的方法在处理单元格较为密集的大表格时,精度相对较低。

自底向上范式一般需要依赖额外的模块预先检测文本或单元格作为基础单元,再预测这些基础单元是否属于同一行、列或单元格从而定位表格结构。所以该范式难以处理包含大量空白单元格或空行空列的表格。

不同于以上两种范式,微软亚洲研究院的研究员们发现基于拆分-合并范式的方法具有更强的可扩展性,在复杂场景中只需要较少的训练数据就能达到很高的精度,而且可以鲁棒地处理包含空白单元格以及空行空列的表格。因此,基于该范式研究员们提出了 TSRFormer。如图3所示,对于输入的表格图像,TSRFormer 先由拆分模块预测出所有行、列的表格分割线,求交点后,生成 N x M 个单元格,再由合并模块预测相邻单元格是否需要合并从而恢复出跨多行、多列的单元格。

图3:TSRFormer 的整体结构图

在以往基于拆分-合并范式的方法中,预测拆分模块的表格线一般通过图像分割模型结合从分割图中提取表格分割线的后处理模块完成(如[2][3]等),而基于规则设计的后处理模块难以处理低质量的分割图,这严重降低了模型针对诸如倾斜、弯曲的表格识别的精度以及泛化能力。不同于既有设计,TSRFormer 提出了一种不需要后处理模块的全新思路:通过直接回归的方式来预测分割线。具体来说,该方法采用每条分割线上的若干采样点来表示该分割线,并让模型直接回归每条分割线上采样点的坐标,从而得到分割线的位置信息。

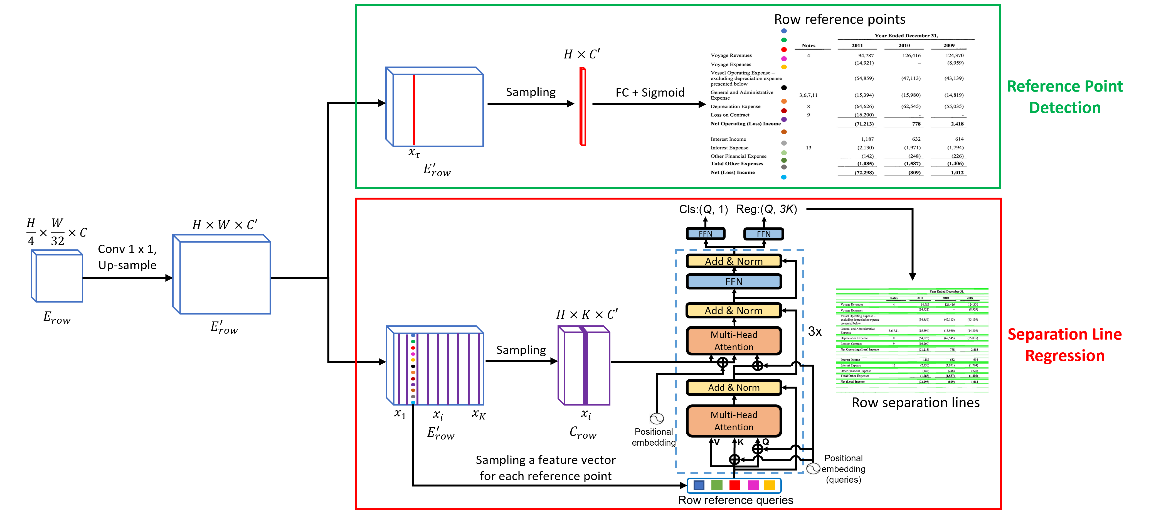

为了让 TSRFormer 能够精确且高效地预测表格分割线,研究员们还提出了一套新的基于两阶段 DETR[4] 的分割线回归算法:SepRETR。如图4所示,在第一阶段中,SepRETR 先用参考点预测模块,为每一条表格分割线预测出一个参考点(reference point);在第二阶段,由这些参考点的视觉以及空间信息组成的特征向量集合作为查询特征(query)输入进一个解码器(Transformer decoder)来回归对应的完整分割线。

图4:基于 SepRETR 的表格分割线预测模型(此处以行分割线为例)

在此基础上,研究员们进一步提出了两个改进算法来提升模型性能:(1)提出了基于先验增强的匹配策略来解决原始 DETR[5] 训练收敛慢的问题;(2)仅采样少量像素的特征作为解码器交叉注意力(cross attention)模块的输入,该方案可以使模型事半功倍,利用较少的计算量即可达到高定位精度。

实验结果及可视化效果

目前,学术界的绝大部分公开数据集都只包含 PDF 或者扫描文档图像中完全横平竖直的表格(如 SciTSR[6]、PubTabNet[7] 等)。与实际应用场景相比,这类数据集较为简单,不能涵盖日常生活中的所有表格类型。近一年,复杂场景中的表格结构识别问题逐渐受到关注,例如去年新发布的 WTW 数据集[8]就开始考虑实际自然场景中的表格。在该数据集中,由于相机拍摄引起的干扰,一些表格会出现倾斜或弯曲,这大大增加了表格结构识别问题的难度。但 WTW 数据集只考虑了分割线均为实线的表格,而没有包含无实线的表格。为了能够更全面地测试模型在各类场景下的性能,研究员们收集了一个更加复杂的数据集,该数据集包含了各式各样复杂场景的样本,例如结构复杂、包含大量空单元格或长跨行跨列单元格的无实线表格,以及倾斜甚至弯曲的表格等等。

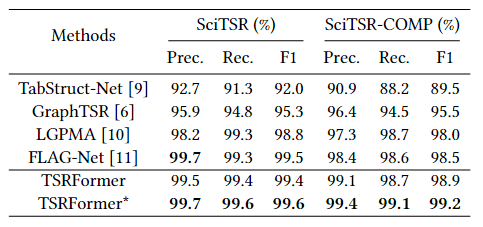

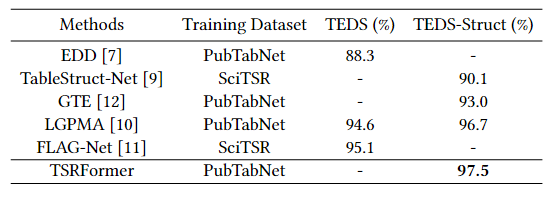

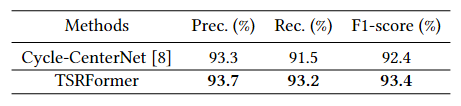

研究员们首先在三个较大规模的公开数据集 SciTSR、PubTabNet 以及 WTW 上验证了 TSRFormer 的性能。从表1、表2以及表3的结果可以看出,无论是在横平竖直的简单场景(SciTSR、PubTabNet)还是在分割线均为实线的自然场景(WTW)表格识别任务上,TSRFormer 均比现有的方法表现得更加优秀。

表1:TSRFormer 与现有方法在 SciTSR 上的性能对比

表2:TSRFormer 与现有方法在 PubTabNet 上的性能对比(其中 TEDS[7] 指标同时考虑表格结构识别和表格内容 OCR 识别的精度,而 TEDS-Struct[10] 仅评测表格结构识别,因此后者更适用于公平比较表格结构识别模型的精度)

表3:TSRFormer 与现有方法在 WTW 上的性能对比

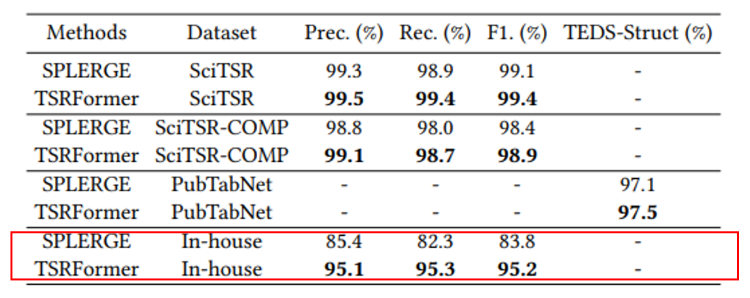

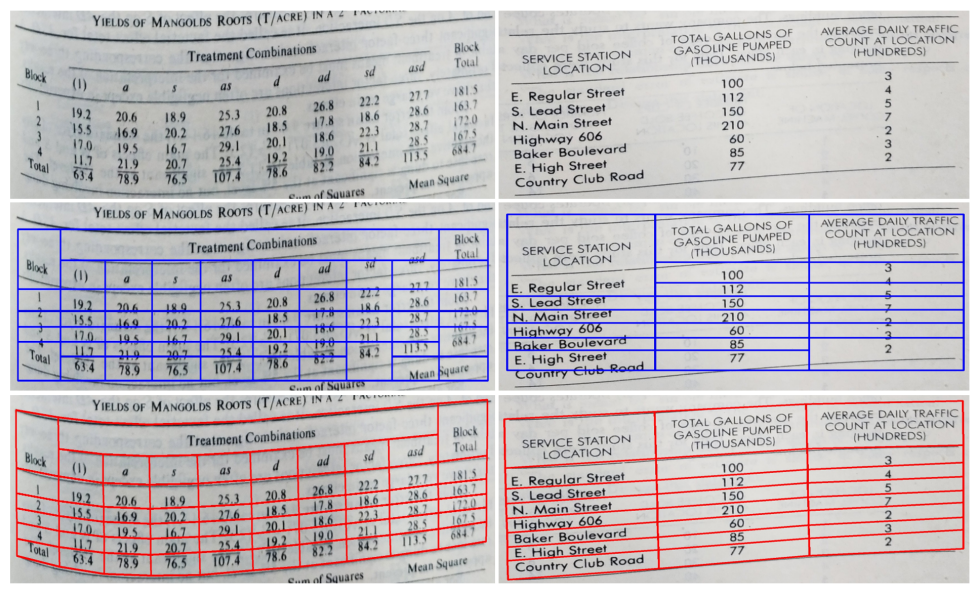

为了进一步验证 TSRFormer 的有效性,研究员们在更具挑战性的内部数据集上开展了实验,并将 TSRFormer 与另外两个基于拆分-合并范式的代表算法——SPLERGE[2] 和 RobusTabNet[3],进行了对比。为了使对比更加公平,在实现这三个方法的时候仅有表格分割线预测的部分不同,其余部分模型结构均保持一致。从表4可以看出,由于 SPLERGE 假设表格是横平竖直的,其在同样是横平竖直场景的数据集 SciTSR 和 PubTabNet 上都能取得接近 SOTA 的结果,但在包含倾斜甚至弯曲的内部数据集上则大幅度落后于 TSRFormer,F1-score 相差了11.4%。图5的可视化效果展示了 SPLERGE 与 TSRFormer 在复杂场景中的明显差距。

表4:TSRFormer 与 SPLERGE 在多个数据集上的性能对比

图5:TSRFormer(红)与 SPLERGE(蓝)的可视化效果对比

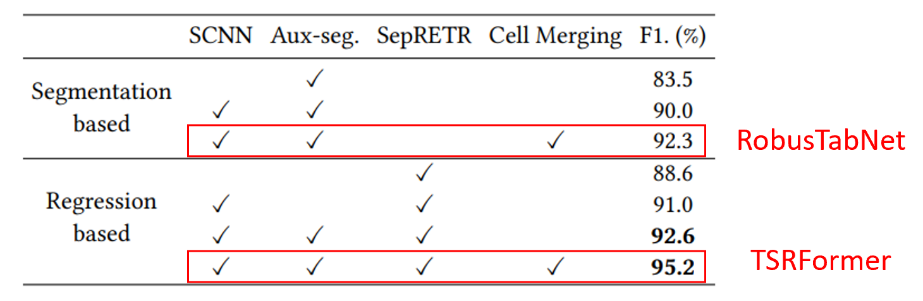

在表5的消融实验中,研究员们将基于直接回归的 TSRFormer 与目前基于图像分割的最优方案 RobusTabNet 进行了对比。TSRFormer 与 RobusTabNet 均能处理倾斜或弯曲的表格。根据表5的实验结果,在更具挑战性的内部数据集中,相比 RobusTabNet,TSRFormer 的 F1-score 高出2.9%。关于消融实验的其他细节,可见论文[1]。

表5:TSRFormer 与 RobusTabNet 在内部数据集上的对比,以及各模块的消融实验

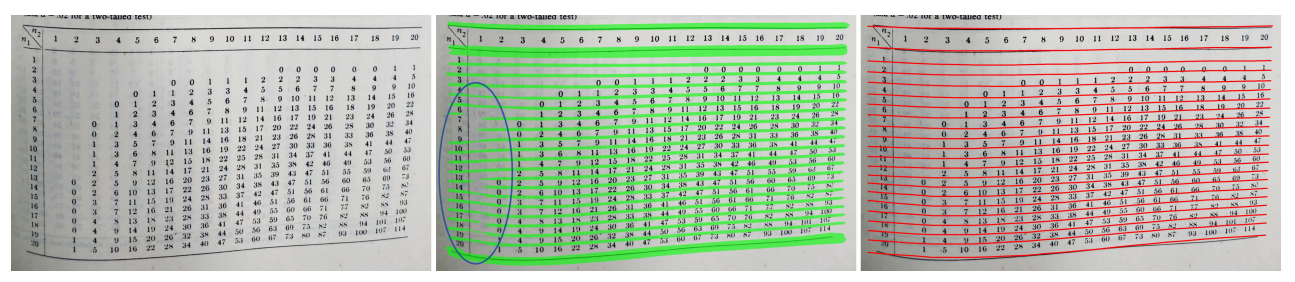

图6中的可视化结果展示了基于直接回归方法的优势。对于图6这种单元格密集、弯曲且含有大面积空白区域的困难样本,基于图像分割的结果并不鲁棒,这使得后续的后处理模块难以提取出正确的分割线。而与之相反,基于直接回归思想的 TSRFormer 并不需要任何后处理模块,对表格中的数据和内容识别得更为精确。

图6:TSRFormer(右) 与 RobusTabNet(中) 的可视化结果对比

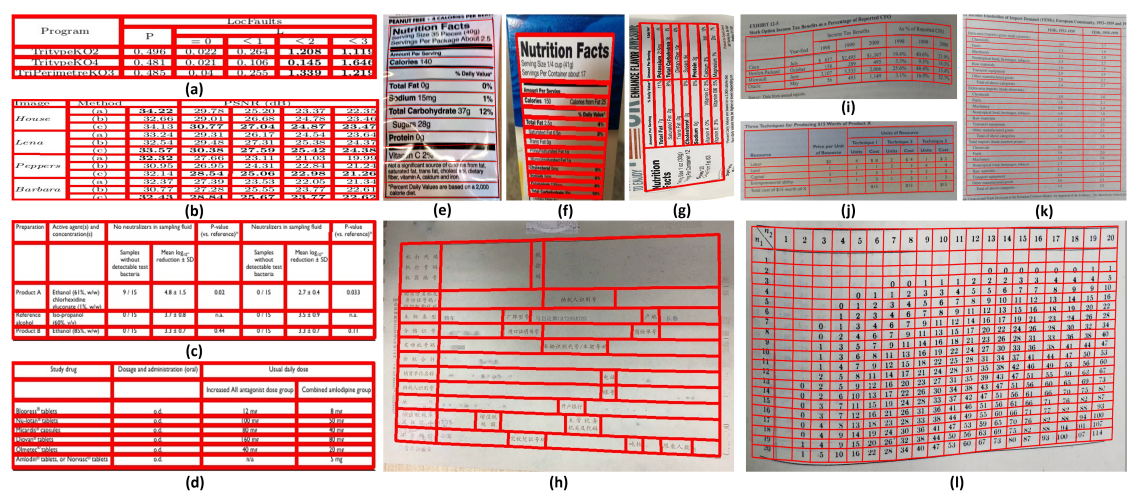

最后,图7展示了 TSRFormer 在多个场景表格图像上的可视化结果,可以看到该方法对于大部分复杂场景表格的识别呈现高鲁棒性。

图7:TSRFormer 在各个数据集上的可视化结果(左右滑动查看更多)。(a-b)来自 SciTSR,(c-d)来自 PubTabNet,(e-h)来自 WTW,以及(i-l)来自内部数据集

未来的挑战

虽然 TSRFormer 在识别大部分场景的表格图像中取得了可喜成果,但要完全解决所有场景的表格结构识别问题道阻且长。主要问题在于,目前的算法只考虑了视觉图像单一模态的信息,而对于内容极为复杂的表格,例如单元格包含多行文字内容或存在极长且无实线的跨行跨列单元格,不仅需要利用图像信息,还需要充分理解图中文字的语义后,才能正确地识别表格结构。此外,现有的方法仍然无法解析多层级的嵌套表格。微软亚洲研究院的研究员们将不断推进表格结构识别的性能,也欢迎同行共同交流、探索该领域更好的技术!

参考文献:

[1] Weihong Lin, Zheng Sun, Chixiang Ma, Mingze Li, Jiawei Wang, Lei Sun, Qiang Huo. TSRFormer: Table structure recognition with Transformers. In ACM Multimedia, 2022.

[2] Chris Tensmeyer, Vlad I. Morariu, Brian Price, Scott Cohen, Tony Martinez. Deep splitting and merging for table structure decomposition. In ICDAR, 2019.

[3] Chixiang Ma, Weihong Lin, Lei Sun, Qiang Huo. Robust table detection and structure recognition from heterogeneous document images. Pattern Recognition, 2023.

[4] Xizhou Zhu, Weijie Su, Lewei Lu, Bin Li, Xiaogang Wang, Jifeng Dai. Deformable DETR: Deformable Transformers for end-to-end object detection. In ICLR, 2021.

[5] Nicolas Carion, Francisco Massa, Gabriel Synnaeve, Nicolas Usunier, Alexander Kirillov, Sergey Zagoruyko. End-to-end object detection with Transformers. In ECCV, 2020.

[6] Zewen Chi, Heyan Huang, Heng-Da Xu, Houjin Yu, Wanxuan Yin, XianLing Mao. Complicated table structure recognition. arXiv:1908.04729, 2019.

[7] Xu Zhong, Elaheh ShafieiBavani, Antonio Jimeno Yepes. Image-based table recognition: Data, model, and evaluation. In ECCV, 2020.

[8] Rujiao Long, Wen Wang, Nan Xue, Feiyu Gao, Zhibo Yang, Yongpan Wang, Gui-Song Xia. Parsing table structures in the wild. In ICCV, 2021.

[9] Sachin Raja, Ajoy Mondal, CV Jawahar. Table structure recognition using top-down and bottom-up cues. In ECCV, 2020.

[10] Liang Qiao, Zaisheng Li, Zhanzhan Cheng, Peng Zhang, Shiliang Pu, Yi Niu, Wenqi Ren, Wenming Tan, Fei Wu. LGPMA: Complicated table structure recognition with local and global pyramid mask alignment. In ICDAR, 2021.

[11] Hao Liu, Xin Li, Bing Liu, Deqiang Jiang, Yinsong Liu, Bo Ren, Rongrong Ji. Show, read and reason: Table structure recognition with flexible context aggregator. In ACM Multimedia, 2021.

[12] Xinyi Zheng, Douglas Burdick, Lucian Popa, Xu Zhong, Nancy Xin Ru Wang. Global table extractor (gte): A framework for joint table identification and cell structure recognition using visual context. In WACV, 2021.