“论文奖项高产户”董力的自我修养:Aim Higher

2021-02-26 | 作者:微软亚洲研究院

编者按:获得国际顶会的最佳论文奖是每一位科研人员的目标。博士毕业刚刚3年的微软亚洲研究院主管研究员董力在2021年伊始连续获得了 AI 领域的两个最佳论文 Runner-Up 奖。今天就让我们一起来看看,他拥有了怎样的天时、地利与人和。

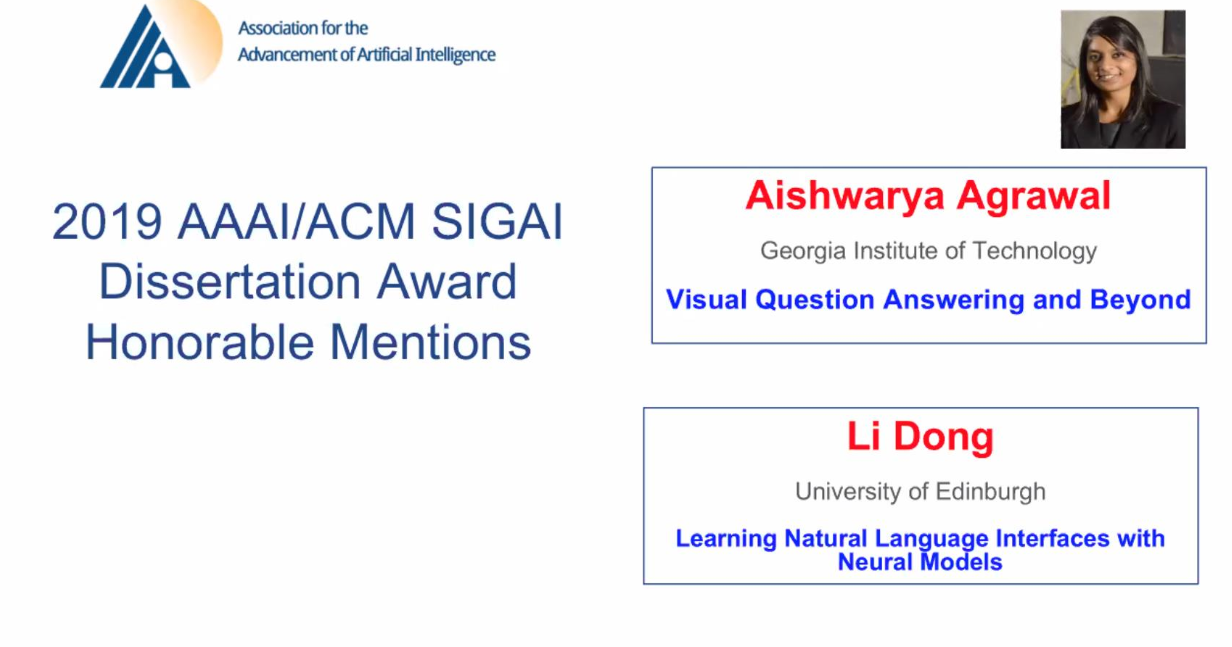

近期,人工智能促进协会 AAAI 联合国际计算机学会 ACM SIGAI 首次发布了博士论文奖,并在今年2月举办的第35届人工智能国际会议 AAAI 上正式公布了三位获奖者的名单。该奖项旨在发现和鼓励人工智能领域的优秀博士研究和论文,并由 AI 领域的国际知名高校每年推举一位候选人参加,奖项的含金量可见一斑。曾在微软亚洲研究院实习、博士毕业于爱丁堡大学的微软亚洲研究院主管研究员董力获得了首届 AAAI/ACM SIGAI 博士论文奖的 Runner-Up 奖。

董力的获奖论文:Learning Natural Language Interfaces with Neural Models [1](用神经模型来学习自然语言接口)的主题是关于基于神经网络的语义解析——将自然语言表达转化成机器可以执行的符号表示,从而通过使用神经网络去构建更好的人机交互自然语言界面。此外,董力的另一篇论文:Self-Attention Attribution: Interpreting Information Interaction Inside Transformer [2],也获得了 AAAI 2021 Best Paper Runner-Up 奖。同时获得两个奖项,可以说是对董力近十年研究积累的认可和褒奖,其背后的支撑是一系列研究理论和技术创新,以及与微软亚洲研究院的深厚渊源。

8年前就开始用深度学习探索NLP,抢得先机

2012年,正在读大四的董力开始了在微软亚洲研究院三年的实习生活。彼时,微软亚洲研究院的研究员们已经用 AI 技术去探索最具挑战性的问题,并在2012年的“二十一世纪的计算”大会上展示了微软实时语音机器翻译系统,实现了语音识别、文本翻译及语音合成三项技术上的巨大突破。这燃起了董力对 NLP(自然语言处理)的兴趣。

当时深度学习初露锋芒,微软的邓力研究员利用相关技术在语音识别等问题上获得了突破。董力的 Mentor 微软亚洲研究院首席研究员韦福如敏锐地察觉到了这一技术变革,鼓励董力从零开始搭建深度学习库,并一起推动了深度学习在自动问答、人机对话、情感分析等问题上的落地。这个契机让董力对 NLP 的经典方法和前沿研究都有了系统的认识。

董力(右)在2015年“二十一世纪的计算”大会上获得微软学者称号,哥伦比亚大学数据科学研究所所长周以真教授(左)为其颁奖

“正是微软亚洲研究院对前沿技术的前瞻性,让我可以很早就接触到深度学习,有机会探究 NLP 研究方向的更多潜力,”董力表示。在微软亚洲研究院“结识”的 NLP 和深度学习,成为了董力此后的研究主线,并且基于这个领域越挖越深,不仅成为“论文高产户”,也成就了此次 AAAI/ACM SIGAI 的博士论文奖。

论文高产户:选对方向,持续发力

董力的博士论文 Learning Natural Language Interfaces with Neural Models,其核心是让机器可以“理解”人类的语言——将自然语言转化成为机器可以理解的结构化、形式化的语言,实现更自然的人机交互接口。在此之前,学术界普遍通过构建多模块流水线模型进行自然语言的语义解析。因为受限于模块之间的错误扩散,以及各种繁杂的人工规则,所以语义解析只能在小部分环境中应用。但董力的研究将符号化的信息与神经网络有机地结合,破解了人们对神经网络能否准确理解自然语言的疑惑,获得了学术界的关注,同时也推动了通用 AI 研究的进步。这之后,董力还针对机器多语义理解进行了研究,并实现了机器对自然语言理解置信度的判断。

这篇获奖的博士论文是董力此前一系列研究工作的一个总结。2016年,董力在 ACL 大会上发表的论文 Language to Logical Form with Neural Attention [3],提出了将自然语言转化为形式化表示的方法,并构建出了相应的神经网络模型来融入形式化语言的语法信息。2017年,他在 EMNLP 大会上发表的论文 Learning to Paraphrase for Question Answering [4],则提出了对同一个含义有多种不同说法的句子进行建模。2018年,他在 ACL 上发表的两篇论文 Confidence Modeling for Neural Semantic Parsing [5] 和 Coarse-to-Fine Decoding for Neural Semantic Parsing [6],分别对语义解析的置信度估计和多粒度解码进行了研究,其中前一篇是在微软雷德蒙研究院实习期间完成的。后一篇也获得了当年的 ACL Best Paper Honorable Mention。

董力在爱丁堡大学博士毕业留影

一切都有迹可循,论文奖项并非凭空而来。董力表示,“我很幸运能够成为业内最早一批接触 NLP 和深度学习这个交叉领域的研究人员,在微软亚洲研究院我跟随着全球顶尖的研究员们,踏上了这个全新的赛道并打下了坚实的基础,所以在博士期间我才得以进一步加速。”2018年董力在完成了博士学业后,再次回到研究院,成为了自然语言计算组的一名研究员。

Aim higher, take a risk!

从学生到研究员的转变,不仅仅是角色上发生了改变,“思维方式也开始有所不同”。董力用计算机领域科研人员特有的方式将这个转变做了一个类比:学生和导师就像生成式对抗网络(GAN)中的生成模型(Generative Model)和判别模型(Discriminative Model)。当“生成器”有了新的想法,要付诸行动时,“判别器”会给出指导和参考,以避免走弯路,从而让“生成器”可以在潜移默化中,通过大量的交流切磋不断成长。

而工作中不再有“判别器”这个角色,从想法到实践,再到走完全过程,更多的事物都需要自己承担。“但是,也只有在工作环境中,你才能接触到更多实际的场景,发现更多现实中存在的问题。比如,对语义分析中置信度估计的这个题目,就是当时在微软雷德蒙研究院实习时,我的 Mentor Chris Quirk 研究员结合可信赖 AI 系统的需求,提出我们应该在这个方向探索的,”董力说。

董力(后排右三)与微软亚洲研究院自然语言计算组的部分同事,在拿到第六届世界互联网大会“世界互联网领先科技成果”奖杯后合影

正式加入微软亚洲研究院的这两年,董力仍然继续从事 NLP 领域的研究,目前他主要关注大规模预训练语言模型。他和团队所做的 UniLM(Unified Language Model,统一语言模型),可以将自然语言理解(NLU)与自然语言生成(NLG)这两种不同的任务统一到一个模型中,从而更好地支持上层应用。他们还将相关方法扩展到了多语言,提出了InfoXLM 模型。这些努力都从底层研究很好地支撑了微软的各项 NLP 应用,也进一步推动了 NLP 科研领域和业界相关应用的发展。

对于研究方法,董力也有一些自己的心得,他介绍道:首先,要尽力打造自己的代表作,一个 milestone、一个 milestone 地攻克,然后将这些点串联起来就可以形成自己的研究主线;其次,一定要协调好长期目标和短期目标之间的关系,不能被短期目标内卷,不然别人换个路径就可以对你进行降维打击,要阶段性地从自己的范围里跳出来进行审视,从不同角度去考察自己的研究;最后,是句老话——要不断创新,而实现创新的一个有效方法就是 aim higher,给自己制定一个稍微高一些的目标,不要害怕失败,因为如果每个项目都成功了,那可能意味着并没有创新而是在求稳,从而会错失一些机会。

参考文献:

[1] Learning Natural Language Interfaces with Neural Models

https://era.ed.ac.uk/handle/1842/35587

[2] Self-Attention Attribution: Interpreting Information Interactions Inside Transformer

https://arxiv.org/abs/2004.11207

[3] Language to Logical Form with Neural Attention

https://www.aclweb.org/anthology/P16-1004/

[4] Learning to Paraphrase for Question Answering

https://www.aclweb.org/anthology/D17-1091/

[5] Coarse-to-Fine Decoding for Neural Semantic Parsing

https://www.aclweb.org/anthology/P18-1068/

[6] Confidence Modeling for Neural Semantic Parsing

https://www.aclweb.org/anthology/P18-1069/