编者按:如今,机器学习已成为人类未来发展的焦点领域,如何进一步拓展机器学习技术和理论的边界,是一个极富挑战性的重要话题。7月23日至29日,第四十届国际机器学习大会 ICML 2023 在美国夏威夷举行。该大会是由国际机器学习学会(IMLS)主办的年度机器学习国际顶级学术会议,旨在推动机器学习领域的学术进步。在 ICML 2023 上,微软亚洲研究院的研究员们有多篇论文入选,今天我们将为大家简要介绍其中的5篇。

发布时间:2023-07-26 类型:深度文章

编者按:如今,机器学习已成为人类未来发展的焦点领域,如何进一步拓展机器学习技术和理论的边界,是一个极富挑战性的重要话题。7月23日至29日,第四十届国际机器学习大会 ICML 2023 在美国夏威夷举行。该大会是由国际机器学习学会(IMLS)主办的年度机器学习国际顶级学术会议,旨在推动机器学习领域的学术进步。在 ICML 2023 上,微软亚洲研究院的研究员们有多篇论文入选,今天我们将为大家简要介绍其中的5篇。

发布时间:2023-07-26 类型:深度文章

编者按:ICML 被认为是人工智能、机器学习领域最顶级的国际会议之一,在计算机科学界享有崇高的声望。ICML 2022 于7月17日-23日以线上线下结合的方式举办。今天我们精选了微软亚洲研究院在此次大会上发表的7篇论文,来为大家进行简要介绍,从强化学习、图神经网络、知识图谱表示学习等关键词带你一览机器学习领域的最新成果!

发布时间:2022-07-21 类型:深度文章

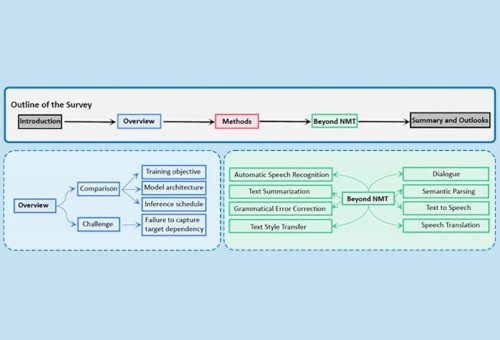

编者按:近年来,由于并行的快速推理能力,非自回归生成在自然语言处理、语音处理等领域展示出了其特有的优势,并日益成为生成模型的研究热点。为了促进非自回归生成模型的发展,微软亚洲研究院与苏州大学的研究员们共同撰写了综述论文“A Survey on Non-Autoregressive Generation for Neural Machine Translation and Beyond”,回顾了非自回归生成在神经机器翻译以及其他任务中的发展,并对非自回归生成的未来提出了展望。

发布时间:2022-05-13 类型:深度文章

ICLR 2022 | 微软亚洲研究院深度学习领域最新研究成果一览

编者按:ICLR(International Conference on Learning Representations)是国际公认的深度学习领域顶级会议之一,众多在人工智能、统计和数据科学领域以及计算机视觉、语音识别、文本理解等重要应用领域极其有影响力的论文都发表在该大会上。今年的 ICLR 大会于4月25日至29日在线上举办。本届大会共接收论文1095篇,论文接收率32.3%。今天,我们精选了其中的六篇来为大家进行简要介绍,其中研究主题的关键词包括时间序列、策略优化、解耦表示学习、采样方法、强化学习等。欢迎感兴趣的读者阅读论文原文,一起了解深度学习领域的前沿进展!

发布时间:2022-04-26 类型:深度文章

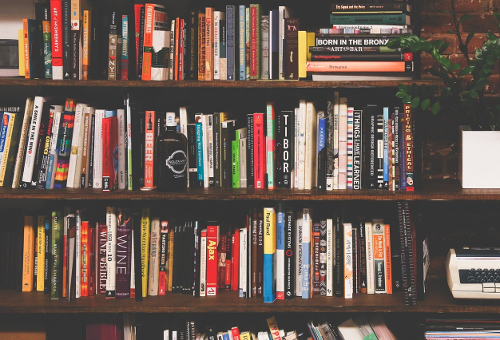

如何自学机器学习?需要哪些数理基础?怎样从入门到进阶,成就大神之路?对于这些问题,作为毕业后投身机器学习研究的数学博士、微软亚洲研究院机器学习组主管研究员陈薇无疑是最有发言权的。在这篇书单推荐中,她从机器学习综述、算法优化、理论延展、数学基础四大方面入手,为大家提供一份机器学习的“完全指南”。

发布时间:2021-09-06 类型:深度文章

KDD Cup 2021 | 微软亚洲研究院Graphormer模型荣登OGB-LSC图预测赛道榜首

在刚刚结束的由 KDD Cup 2021 和 Open Graph Benchmark 官方联合举办的第一届 OGB Large-Scale Challenge 中,来自微软亚洲研究院的研究员和大连理工大学等高校的实习生们通过借鉴 Transformer 模型的思路,创新性地提出了可应用于图结构数据的 Graphormer 模型,在大规模分子性质预测任务中击败了全球包括 DeepMind 在内的多个技术实力强劲的公司和研究机构,取得了第一名的佳绩。

发布时间:2021-06-20 类型:深度文章

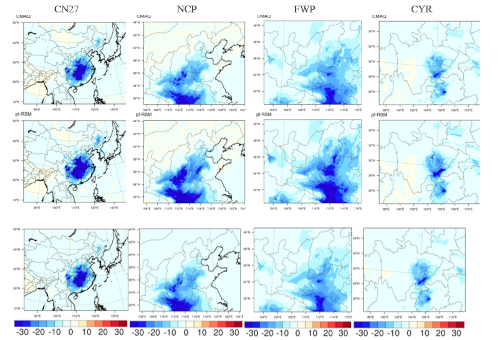

微软与清华大学联合提出DeepRSM模型,以AI助力空气污染治理

控制和减少污染物排放是治理空气污染的重要手段,精准的排放-污染物浓度响应曲面可以帮助决策者快速找到效果更好的减排方案。但传统排放-污染物浓度响应曲面需要依赖 CTM 模型进行模拟,其存在计算量庞大、运行耗时耗力、时效性低等问题。对此,微软亚洲研究院与清华大学联合提出 DeepRSM 模型,能够精细地刻画空气污染物浓度,帮助决策者快速找到减排效果更好、成本更低的方案。该研究发表在环境科学顶级期刊《环境科学与技术》上。

发布时间:2020-07-15 类型:深度文章

WMT 2019国际机器翻译大赛:微软亚洲研究院以8项第一成为冠军

近日,由国际计算语言学协会ACL(The Association for Computational Linguistics)举办的WMT 2019国际机器翻译比赛的客观评测结果揭晓,微软亚洲研究院机器学习组在参加的11项机器翻译任务中,有8项获得了第一名,另外3项获得第二名,凭借多维度的技术创新成为冠军团队。

发布时间:2019-04-22 类型:深度文章